Qué es un modelo LLM explicado fácil: cómo funciona ChatGPT por dentro

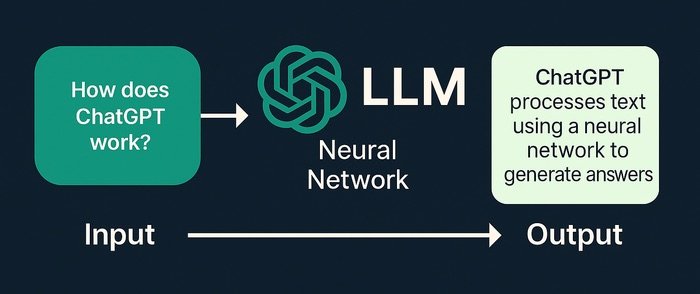

ChatGPT, Gemini, Claude… Seguro que has oído hablar de ellos mil veces, pero casi siempre desde fuera: “una IA que responde”, “un chat inteligente”, “un asistente virtual”. Detrás de todos ellos hay una misma idea: un modelo LLM. En este artículo te explico qué es un LLM, cómo funciona por dentro y por qué ChatGPT es capaz de “entenderte” y responderte con tanta naturalidad, sin tecnicismos innecesarios.

Qué significa LLM y por qué todo el mundo habla de ello

LLM son las siglas de Large Language Model, que en español se suele traducir como “modelo de lenguaje grande”. Es un tipo de inteligencia artificial especializada en trabajar con texto: leerlo, generarlo, resumirlo, traducirlo, responder preguntas, etc.

Se llama “grande” porque está entrenado con una cantidad enorme de ejemplos de texto (libros, webs, artículos, código, conversaciones…) y porque internamente tiene millones o incluso miles de millones de parámetros, que son los “ajustes” internos del modelo.

La idea clave es esta:

Un LLM es un modelo capaz de predecir la siguiente palabra de una frase, basándose en todas las palabras anteriores y en lo que “ha aprendido” del idioma.

Puede sonar simple, pero con el tamaño y la complejidad actuales, esa predicción de palabras se convierte en algo muy parecido a “entender” lo que quieres decir.

ChatGPT no “piensa” como una persona: predice la siguiente palabra

Cuando escribes algo en ChatGPT, no hay una persona al otro lado, ni una base de datos con respuestas pregrabadas. Lo que ocurre es que el modelo:

- Toma tu mensaje y lo transforma en una representación interna (números).

- Evalúa, palabra a palabra, cuál es la respuesta más probable dada tu pregunta y todo lo que ha aprendido antes.

- Genera la respuesta una palabra (o trozo de palabra) cada vez, muy rápido.

No “mira en Google”, ni va a buscar información en tiempo real (salvo que el sistema lo conecte a un navegador, como hacen algunas versiones). Lo que hace es usar patrones estadísticos del lenguaje para construir una respuesta que encaje con lo que has pedido.

Qué son los “tokens” y por qué son tan importantes

Para que un modelo LLM pueda trabajar con texto, no puede usar directamente letras o palabras tal cual. Por eso se usa el concepto de token.

Un token es una especie de pieza mínima de texto. Puede ser:

- Una palabra entera: “casa”

- Una parte de palabra: “re” + “comen” + “dado”

- Un símbolo: “?”, “.”, “!”

El LLM no ve “frases”, ve secuencias de tokens que luego transforma en números para poder operar con ellos. Cuando dices “Hola, ¿cómo estás?”, internamente se convierte en algo del estilo:

[“Hola”, “,”, “¿”, “cómo”, “estás”, “?”] → y de ahí a una lista de números.

Cómo “aprende” un modelo LLM: entrenamiento masivo

El proceso para construir un modelo como ChatGPT tiene dos grandes fases:

1. Entrenamiento con texto a gran escala

Primero, el modelo se entrena con una cantidad gigantesca de texto. El objetivo del entrenamiento es que el modelo aprenda a:

- Completar frases de forma coherente.

- Respetar la gramática y el estilo del idioma.

- Relacionar conceptos (por ejemplo, que “iPhone” tiene relación con “Apple”, “móvil”, “smartphone”).

Durante este entrenamiento, el sistema comete errores constantemente: predice una palabra, se comprueba si acertó o no, y se corrigen sus parámetros internos para que la próxima vez se acerque más a la respuesta correcta. Esto se repite millones y millones de veces.

2. Ajuste fino (fine-tuning) y entrenamiento con feedback humano

Una vez el modelo ya domina el lenguaje en general, se afina para que:

- Responda de forma más útil.

- Sea más educado y seguro.

- Evite, en lo posible, contenidos dañinos, ofensivos o peligrosos.

En esta etapa, personas humanas revisan respuestas, indican cuáles son mejores, corrigen estilos y ayudan a guiar cómo debe responder el modelo. Este proceso se conoce como aprendizaje con refuerzo a partir de feedback humano.

Qué son los parámetros y por qué se habla de “miles de millones”

Cuando escuchas que un modelo tiene “70.000 millones de parámetros” o similares, se refiere al número de “perillas” internas que el modelo puede ajustar durante el entrenamiento.

Un parámetro es básicamente un número que el modelo puede modificar para aprender cómo relacionar unas palabras con otras. Cuantos más parámetros tiene:

- Más patrones puede aprender.

- Más matices puede capturar.

- Pero también requiere mucho más cálculo y recursos para entrenar y funcionar.

Podemos imaginarlo como un gran panel de controles con millones de ruedas diminutas. Durante el entrenamiento, el sistema las va ajustando una y otra vez hasta encontrar una configuración que le permita “entender” y generar texto de forma muy competente.

Qué hace ChatGPT exactamente cuando le escribes un mensaje

Cuando tú escribes algo en ChatGPT, por dentro pasan varias cosas:

- Tokenización: tu texto se trocea en tokens.

- Codificación: esos tokens se convierten en números (vectores).

- Procesamiento por el modelo: esos números pasan por muchas capas internas (neuronas artificiales) que calculan qué token debería ser el siguiente.

- Generación paso a paso: el modelo elige el siguiente token, lo añade al texto, y vuelve a calcular el siguiente, y así hasta completar la respuesta.

- Detokenización: convierte de nuevo esos tokens en palabras legibles.

Todo eso sucede en milisegundos o pocos segundos, dependiendo de la longitud de tu mensaje y de la respuesta.

Por qué a veces se equivoca o “alucina”

Aunque ChatGPT parece muy listo, no es infalible. Hay dos ideas clave para entender sus errores:

- No tiene “memoria perfecta” ni acceso automático a internet (salvo en versiones que lo integren con un navegador). Responde basándose en lo que aprendió en su entrenamiento, no en una búsqueda en tiempo real.

- No “entiende” la verdad del mundo, sino patrones de palabras. Si hay pocos ejemplos fiables sobre un tema, puede inventar detalles que “suenan bien” pero no son ciertos. A esto se le llama alucinación.

Por eso siempre es buena idea:

- Contrastar datos importantes con fuentes oficiales.

- No usarlo como única referencia en temas legales, médicos o financieros.

Qué hace que ChatGPT parezca tan “natural” al escribir

Varias características contribuyen a esa sensación de naturalidad:

- Entrenamiento con mucho texto real: libros, artículos, conversaciones… Eso le da variedad de estilos y registros.

- Contexto amplio: puede tener en cuenta muchos tokens previos (tu pregunta + parte del historial) para generar respuestas coherentes.

- Ajuste por estilo: durante el fine-tuning se le enseña a ser más claro, educado y útil, evitando respuestas demasiado técnicas cuando no hacen falta.

- Capacidad de seguir instrucciones: está optimizado para entender frases como “explícalo fácil”, “en viñetas”, “en tono formal”, etc.

Ventajas de los LLM como ChatGPT

Los modelos LLM han abierto una etapa nueva en la forma de trabajar con información. Algunas ventajas claras:

- Versatilidad: sirven para escribir, resumir, traducir, programar, explicar conceptos, generar ideas, etc.

- Interfaz natural: solo necesitas escribir texto, sin aprender comandos complejos.

- Productividad: permiten hacer borradores, revisar textos, generar código base y acelerar muchas tareas repetitivas.

- Accesibilidad: pueden adaptar explicaciones a diferentes niveles de dificultad.

Limitaciones y cosas que hay que tener en cuenta

Al mismo tiempo, es importante no idealizar lo que puede hacer:

- No tiene conciencia ni emociones: aunque escriba “como si” las tuviera, no siente ni decide como un humano.

- Puede estar desactualizado: su conocimiento depende de hasta cuándo se entrenó y de si está conectado o no a fuentes externas.

- Puede mezclar datos correctos con errores: especialmente en temas muy recientes, muy específicos o poco documentados.

- Necesita supervisión: idealmente, debe verse como una herramienta de apoyo, no como un oráculo infalible.

En resumen: cómo funciona ChatGPT por dentro, en una frase

Si tuvieras que quedarte con una sola idea, sería esta:

ChatGPT es un modelo de lenguaje grande (LLM) que ha aprendido, a partir de millones de ejemplos, a predecir la siguiente palabra de forma muy inteligente, hasta el punto de poder sostener conversaciones, explicar conceptos y ayudarte a trabajar con texto de manera sorprendente.

Entender esto te ayuda a aprovechar mejor la herramienta: sabes que es muy potente con lenguaje, pero también que tiene límites y que siempre conviene usar tu propio criterio.

Deja una respuesta